Livre X : Le monde du probable

Table des articles Livre X

Les articles sont répertoriés dans un ordre approximatif « au hasard ».

Il y a certainement des redites, mais chaque article peut être lu séparément dans un contexte différent.

— Petit précis de stochastique. page 1

— Péambule 4

— Le hasard est-il domptable ? 8

— Dualité du concept de probabilité 11

— Aperçu sur le calcul des probabilités 14

— La loi normale 24

— La courbe en cloche 36

— Au hasard 44

— Le hasard, degré 0 de l’information 46

— Le hasard est bizarre 49

— Par hasard 52

— Dieu sait-il jouer aux dés ? 55

— Des dés 58

— La chéance des dés 62

— Entre 0 et 1 ou de l’impossible au certain 63

— La maîtrise de l’incertitude 66

— Le probable et l’innombrable 69

— Joindre l’utile au probable 72

— Le flair du probable 75

— La bourse et la vie 78

— La régression vers la moyenne 81

— Au hasard des rencontres 83

— La théorie de l’évolution et les probabilités 86

— Le miracle est-il probable ? 89

— Les aléas du hasard 92

— Hasard ou nécessité 95

— Les degrés de croyance 98

— Le tir à l’arc 100

— Le mouvement brownien 102

— L’attendu 107

— La logique du flou 110

— Le hasard est égal 112

— L’inattendu 116

— De 0 à 1 ou le tiers exclu, entre le rien et le tout 119

— {0, 1}N 124

— L’argument du Dominateur 125

— L’imprévisibilité du passé 128

— L’incertitude du présent 130

— La pensée, la conscience et les probabilités 134

— Les probabilités et la mort ou la certitude de la mort 137

— Le principe de précaution 140

— Peut-on fabriquer du hasard ? 142

— Superstition 145

— Le jeu de pile ou face, atome du probable 147

— La loi des grands nombres 151

— Définition possible de la loi des grands nombres 156

— La loi des grands nombres ou le théorème d’or 158

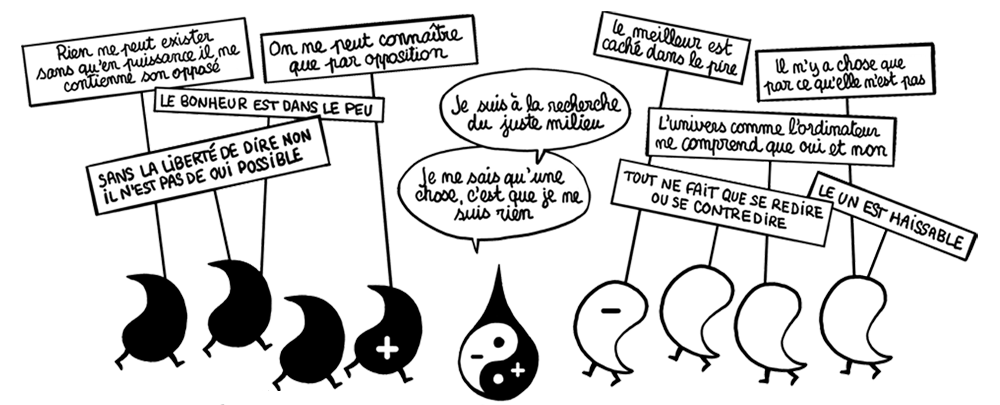

— Aphorismes sur le hasard 167

— Théorie de l’information 169

— Essai de définition de l’information ou la dimension invisible 171

— Théorie de l’information ou théorie statistique de la communication 174

— Rien ne se perd, rien ne se crée, tout se paye ou le coût de l’information 183

— La vitesse de l’information 0 o v o c 186

— Généralisation du concept de l’information 189

— L’entropie 197

— Bruits 205

— La théorie des jeux 209

— Réflexions sur le hasard et le jeu 221

— Le dilemme du prisonnier 224

— Théorie de la décision 226

— La théorie des catastrophes 228

— Certitude de l’incertitude 231

— Le hasard instable 233

— Considération météorologiques – L’ONA 235

— L’homme probable 238

— Le hasard déterminé 244

— Quand le hasard ondule ou l’illusion de la continuité de l’onde 247

— Tout a un prix 250

— L’échantillon 251

— Loi des 80/20 ou loi de Pareto 253

— Pour un essai de définition du concept de probabilité 254

— Probabilité et fractalité 257

— Les chemins de hasard 259

— Les écarts à la moyenne et leur dispersion. La diaspora de l’énergie 260

— Oui, non, peut-être ou l’être, le néant et le possible 266

— Le probable et le possible 269

— La logique du flou 270

— Le jeu du pile ou face ou l’atome primordial 272

Articles extraits du livre X Le monde du probable

La régression vers la moyenne

Dans la courbe en cloche, la moyenne est la droite verticale qui partage symétriquement la courbe en deux. Tous les écarts de probabilité se font horizontalement à partir de la droite moyenne. La moyenne porte le joli nom d’espérance mathématique. Elle signifie que pour un grand nombre d’expériences les probabilités des résultats de ces expériences vont se placer sur la courbe en cloche. Mais à la longue, tous ces écarts vont s’équilibrer autour de la moyenne à cause du phénomène de compensation. Les mini détails négatifs ou positifs vont plus ou moins s’accumuler pour produire un écart qui pourra être, suivant le total, d’un côté ou l’autre de la moyenne. Ces écarts au total vont s’égaliser et se répartir autour de la moyenne.

C’est finalement cette moyenne que l’on atteint au bout d’un grand nombre d’expériences. Elle ne l’est jamais complètement, car pour cela il faudrait un nombre infini d’expériences. La moyenne oscille constamment et chaque correction en entraîne une autre, inverse. C’est un peu comme une onde qui ne peut mourir par l’annulation de son amplitude. Une oscillation en entraîne toujours une autre en sens inverse quelle que soit son amplitude. L’impossible réduction à zéro de l’amplitude entraîne toujours une réplique. La moyenne est ainsi une valeur attractive jamais atteinte. Elle est à ranger dans le camp des inaccessibles, comme le zéro et l’infini. Tout tourne autour de cette moyenne comme une guirlande, un écart est une dépense d’énergie. Même si cette dépense d’énergie est la plus réduite possible, elle produira un effet inverse. L’annulation de toute énergie correspondrait à un état de repos qui n’existe pas dans la nature. Le repos doit être relatif à un repos qui lui aussi ne peut être sans se référer à un autre. La situation de repos absolu est aussi un inaccessible.

Comment expliquer le rôle attracteur de la moyenne ?

Dans un de ses livres, Stephen Jay Gould compare les performances des anciens joueurs de base-ball à celles des joueurs actuels. Il note que les anciens atteignaient un pic de performance difficilement égalable mais ceci était rare. Par contre les joueurs actuels jouent mieux, plus régulièrement, mais n’atteignent plus les performances des anciens. Cela était dû, pensait-il, à leur entraînement intensif. Ceci est un exemple de ce que l’on appelle la régression vers la moyenne. Quand quelque chose a bien réussi c’est-à-dire s’est bien écarté de la moyenne, les écarts suivants sont plus près de la moyenne, donc moins bons.

Ceci pose une importante question. Des génies comme Bach, Mozart, Michel-Ange, Shakespeare et d’autres ont été tout à fait exceptionnels dans leur siècle et ont largement dominé leurs concurrents. Cela signifie que l’exceptionnel peut surgir du médiocre. Mais si maintenant on donne à un grand nombre de personnes un niveau de connaissance, une éducation, un apprentissage, une culture, largement répartis, alors il devient plus difficile à un génie de s’affirmer. Tout se nivelle par le haut et le bas. Effectivement nous n’avons pas connaissance d’un Mozart moderne. Le niveau s’étant élevé, cela a fait abaisser la possibilité des extrêmes. Un Gauss, un Victor Hugo ne sont plus apparemment possibles. On régresse vers la moyenne. Cette moyenne à la limite est terne et sans-vie. On ne peut y séjourner. Les pics des temps anciens s’érodent et les vallées se remplissent. On va vers l’aplatissement. La responsable de tout cela, on la connaît : c’est l’expansion qui n’a de cesse de vouloir s’étaler et de détruire ce que réunit la gravitation.

Si Bach ressuscitait, trouverait-il le terrain nécessaire à l’éclosion de son génie ? Probablement pas. Il aurait beaucoup plus de difficulté à s’imposer.

Le hasard est égal

Dans ses discussions épistolaires avec Fermat, en 1654, Pascal qui désire introduire le calcul dans le partage du gain ou de la perte lorsqu’un jeu d’argent s’interrompt brusquement, emploie l’expression « le hasard est égal ». En écrivant cela, Pascal obéit à son intuition, mais ce raisonnement n’est pas rigoureux et n’a pas l’esprit géométrique qu’il a si bien développé. Sa « géométrie du dé » repose en effet sur une pétition de principe. Dire « le hasard est égal » équivaut au concept d’équiprobabilité qui sera repris plus tard par Laplace dans son essai philosophique sur les probabilités (1825) que nous citons : «La théorie des hasards consiste à réduire tous les évènements du même genre à un certain nombre de cas également possibles c’est-à-dire tels que nous soyons également indécis sur leur existence et à déterminer le nombre de cas favorables à l’évènement dont on cherche la probabilité. Le rapport de ce nombre à celui de tous les cas possibles est la mesure de cette probabilité qui n’est ainsi qu’une fraction dont le numérateur est le nombre de cas favorables et dont le dénominateur est le nombre de tous les cas possibles ».

Remarquons d’emblée que ce raisonnement est purement destiné à l’usage spécifique des hommes. La nature contrairement à l’homme ne choisit pas. Elle est conduite par un enchaînement de faits qui s’effectuent sans qu’il y ait une ombre d’intention. Pour la nature le résultat est indifférent. Elle n’a pas voulu les êtres vivants qui ne sont que le résultat de rencontres fortuites. L’homme lui, personnalise ses options. Dans le jeu des dès, il souhaite la sortie d’un chiffre sur lequel il a joué. Le mot favorable n’est qu’une convention entre joueurs. La nature n’a pas de préférence. Nous avons montré par ailleurs qu’elle ne sait que se reproduire à l’identique stupidement en commettant des ratés, des erreurs qui vont produire du nouveau purement accidentel.

L’homme est orienté vers l’utile. Tout son comportement consiste à chercher à améliorer son bien-être par la mise en jeu du procice et la lutte contre ce qui lui est funeste. Son objectif est ainsi clairement désigné et le calcul des probabilités a été inventé par lui pour y parvenir. Il s’est bâti une certaine logique qu’il s’empresse de trahir. Lorsque Laplace parle « d’évènements également possibles » il s’appuie sur le probable lui-même. Tout repose sur la formule « également probable » qui implique que la probabilité est déjà définie. C’est une pétition de principe, ce qui consiste à considérer comme vrai ce que l’on veut précisément démontrer.

L’équiprobabilité n’est-elle qu’une notion abstraite ? On peut la retrouver lorsqu’on réalise un certain nombre d’expériences identiques, indépendantes les unes des autres jusqu’à l’infini. On constate en effet que dans ce cas on obtient des résultats approchants qui se confondent, à la condition de répéter indéfiniment ces expériences. C’est une démonstration de l’hypothèse laplacienne, mais on se heurte à trois impossibilités :

1/ aucun évènement n’est parfaitement identique à un autre.

2/ tout dans notre monde est interconnecté, ce qui implique qu’il ne peut y avoir d’évènement parfaitement isolés.

3/ la néccessité d’un nombre infini d’expériences pour atteindre la vraie valeur de la probabilité qualifiée alors joliment d’espérance, est, bien entendu, inaccessible.

On ne peut donc pas obtenir une définition rigoureuse de la probabilité, n’en déplaise à Pascal et à Laplace.

Gauss s’empare du problème d’une manière plus pragmatique. Nous expliquons sa méthode par ailleurs qui est celle de répartir les erreurs inévitables d’une mesure sur sa fameuse courbe en cloche.

D’autres méthodes sont utilisées comme celles de la logique inductive de Keynes.

Les résultats sont de toute façon les mêmes. Il est impossible d’atteindre la rigueur des mathématiques. Cela semble justifié par le terme probabilité lui-même qui implique une absence de certitude, quelque chose de flou et d’imprécis. Il y a une distribution, une dispersion, un écartèlement des valeurs souhaitées et non souhaitées, convergeant vers une valeur moyenne et limite.

Le concept de probabilité bien que vague reste cadré dans certaines limites évaluables. C’est d’ailleurs tout l’objet du calcul des probabilités, de mieux cerner des valeurs aléatoires et de les approximer le plus possible pour obtenir des prévisions à faible variation. Ceci est réalisé par les mathématiques financières, d’un haut degré de sophistication, permettant de réduire le risque au minimum. Ces outils forgés par une extension du calcul des probabilités accessibles seulement par quelques cerveaux permettent aux compagnies d’assurance, aux banques, à des fonds de pension, des fonds souverains, des fortunes personnelles d’accumuler des fortunes colossales avec un minimum de risque en resserrant l’intervalle de confiance. L’argent va à l’argent, c’est bien connu.

A noter que dans la théorie cinétique des gaz on considère tous les états d’un système qui se maintient dans les mêmes conditions de température et de pression. Tous ces états sont réputés équiprobables. C’est l’hypothèse ergodique qui est un postulat ou axiome de base. Ceci permet d’éviter la faute logique de l’affirmation : le hasard est égal.

Le hasard pur est de l’action sans raison. Rationaliser le hasard est donc un oxymore. Le calcul des probabilités y parvient en maîtrisant le flou et l’imprécis et en en fixant les limites.

La véritable raison de l’équiprobabilité est ce que Bernoulli appelait « le principe de raison insuffisante »; ce qu’on pourrait traduire plus brutalement en disant qu’il s’agit du « principe d’égale ignorance ».

Calcul des probabilités.— François Dress – Dunod 1980.

Si le hasard est ignorance, on peut passer du hasard égal à l’égale ignorance. On transpose le problème sur un plan négatif c’est-à-dire sur un manque égal de données. En définitive, on bute sur le mot égalité. Ce concept est un leurre. Il vaut mieux le contourner en parlant d’inégalités. En jetant une pièce de monnaie, on fait approximativement le même geste qui est cependant toujours légèrement différent. Ce sont ces faibles différences qui par leur grand nombre vont se détruire l’une l’autre sans finalement y parvenir tout à fait. On trouvera ainsi après un grand nombre de jets, une quantité

« sensiblement égale » de piles et de faces sans l’être strictement. L’addition de gestes légèrement différents donne une relative égalité sur laquelle on peut se fonder pour faire des prévisions. Le concept d’équiprobabilité n’est qu’approchant. Une pièce de monnaie jetée en l’air possède deux états qui se confondent. Elle est à la fois pile et face. C’est finalemenent son arrêt brusque sur un plan qui va permettre son observation et constater qu’elle montre le côté pile ou face. L’indétermination du résultat est due à l’ignorance de son parcours exact, mais les résultats d’une approximative égalité de piles et de faces sont dues aux légères variations de ce parcours en l’air qui se compensent à la longue, plus ou moins.

Le néant est de probabilité nulle.

« Jean Sébastien Bach

est le cinquième évangéliste.»

Cioran

La loi des grands nombres

ou le théorème d’or

Donnons d’abord une idée de ce que peut être un grand nombre à partir du jeu de bridge qui comporte 52 cartes différentes que l’on distribue, en les battant, équitablement, à 4 joueurs, soit 13 cartes par joueur. Combien y a-t-il de manières de réunir 13 cartes dans une seule main ? Les joueurs ne pensent pas vraiment à ce nombre sans s’imaginer qu’il est fantastique. Il faut calculer.

52 ! / 13 ! . 13 ! . 13 !. 13 !

N ! signifie factorielle n c’est-à-dire :

1x 2 x 3 x 4 x 5 …….. x (n-2)x(n-1) x n. On trouve 5,36×1028. Si un joueur joue 200 fois par jour pendant 100 ans soit 7,3×106. fois, il n’a pratiquement aucune chance de retrouver la même donne!

Selon la doctrine du dualisme moderne, la nature est un immense jeu de pile ou face. Un évènement se produit ou ne se produit pas, à partir d’une situation virtuelle ou probable qui contient, à la fois, la possibilité de se produire et de ne pas se produire. Si cela arrive n fois, le nombre de variantes est de 2 n. Par cette façon exponentielle de multiplier 2 par lui-même n fois, on obtient rapidement d’énormes quantités. Un nombre fantastique également est le nombre de molécules d’air que l’on aspire. En quelques aspirations on en avale 6 x 1023, soit à peu près plusieurs milliards de milliards de milliards ! Tout cela s’emmêle, s’intrique et interagit. L’expansion, par son pouvoir de désagrégation démultiplie et pulvérise pour qu’il y ait, finalement, un incroyable fourmillement d’évènements à n’importe quelle échelle. Dans cet inextricable fouillis, nous ne pouvons rien appréhender. Nous sommes complètement désarmés.

Heureusement pour défricher cela, la loi des grands nombres vient à notre secours. Nous ne pouvons connaître que par elle. Grâce à elle il va apparaître des régularités là où il n’y a qu’irrégularité et désordre. Par quel miracle ?

Insistons d’abord sur le fait que si nous pouvons observer et mesurer individuellement des particules comme l’électron nous ne savons pas de quoi sont faites ces particules et leurs dimensions. Une particule ne peut jamais être isolée complètement, elle communique avec ses consœurs continuellement et on ne peut les séparer. Le très grand nombre est une nécessité de la nature absolument incapable comme l’homme d’exhiber un être totalement indépendant qui ne peut se comparer qu’à lui-même. On ne peut pas plus isoler vraiment quelques particules regroupées. Le très grand nombre d’éléments apparemment identiques est inhérent, intrinsèque, incontestable. Ce grand nombre nous empêche de pouvoir considérer les états de chaque particule. A un certain degré d’échelle, nous ne pouvons absolument pas maintenir les caractéristiques de chaque constituant. C’est le brouillard total, répandu sur ces micro-évènements obscurcissant le pouvoir limité de notre perception, de notre faculté d’observer et de mesurer. La connaissance a ainsi ses frontières. Dans l’histoire de l’humanité il s’est produit beaucoup d’évènements qui ont fait descendre l’homme de son piédestal d’être exceptionnel (héliocentrisme, psychanalyse, darwinisme…). On a cru pendant longtemps à des lois parfaitement déterministes comme la mécanique newtonienne. Force est de constater maintenant qu’elles ne sont que probabilitaires. Nous y reviendrons. Si comme l’affirme Kant « nous ne connaissons « a priori » des choses que ce que nous y mettons nous-mêmes, » il faut se rendre à l’évidence que dans l’ignorance des micro-détails notre faculté de savoir se réduit à un survol statistique des menus évènements qui sont essentiellement aléatoires. Essayons de voir comment on peut passer d’une incertitude quasi totale à une certitude probabiliste autrement dit, une incertitude fortement encadrée.

Le vide quantique est ce qui reste lorsqu’on ôte les particules détectables et leur communication rayonnante. Cela pourrait être le vide absolu. En fait, on parle d’énergie de point zéro c’est-à-dire au voisinage du zéro absolu. Quelques expériences semblent montrer qu’à ce niveau il y a une énorme activité qui se traduit par d’innombrables micro-particules en mal d’être, crépitant comme des gouttes d’eau projetées sur une plaque chauffée à blanc, bruit de fond fluctuant de l’univers, qui s’éteignent à peine nées. En effet leur quantité d’action, c’est-à-dire leur énergie par le temps, est plus

faible que le seuil « h » ou constante de Planck qui devient empiriquement détectable. Ne pouvant accéder à la notoriété du réel,

elles disparaissent dans un temps extrêmement bref. Chaque micro-particule est dotée d’une masse très faible qui en apparaissant a produit un trou, un manque dans le fonds d’énergie, compensant le prélèvement d’énergie. C’est un adage de l’univers, tout se paye, et si quelque chose se crée, quelque chose se perd en contrepartie. Chaque micro-particule peut être animée d’une vitesse. Le choix de ce vecteur vitesse se fait parmi toutes les directions possibles sur 360°. Vient alors la notion de hasard qui était contenu dans le néant, sans, bien entendu, pouvoir s’exprimer. Comme il faut un trou d’énergie pour compenser la petite masse de la micro-particule, une direction prise doit être compensée par une direction inverse d’une micro-particule voisine. La compensation de la masse et de la vitesse d’une micro-particule est indispensable si l’on veut que le hasard pur règne dans ce vide quantique. Le hasard pur, c’est-à-dire ce qui n’a ni cause ni effet, ce qui agit sans raison ne peut conserver son statut que s’il n’y a pas de prélèvement d’énergie sans un manque et que si toutes les vitesses sont équiprobables. Le calcul des probabilités est embarrassé par la définition de l’équiprobabilité, car pour ce faire il est contraint de définir la notion de probabilité ce qui est une pétition de principe où la démonstration est déjà incluse dans l’énoncé. On résout cette difficulté en rendant identiques les notions de hasard et d’équiprobabilité. L’un ne va pas sans l’autre. La moindre situation privilégiée détruit immédiatement la notion de hasard. Pour que le hasard soit pur, il faut une parfaite identité des évènements qui se répètent à l’infini. Il faut aussi qu’il y ait indépendance parfaite sinon ce n’est plus le hasard. Equiprobabilité, indépendance, incompatibilité et totale liberté sont les conditions nécessaires d’un hasard absolu. Mais il n’y a jamais parfaite identité de masse et de vitesse et les micro-particules ne peuvent être totalement indépendantes, communiquent si peu que ce soit entre elles et s’influencent réciproquement. Il y a donc de petits aléas que l’on peut appeler fautes. Elles sont d’autant plus aisées que leur milieu se distend par l’expansion qui sévit majoritairement en tous points de l’univers. Que se passe-t-il au voisinage du zéro ? Dans l’ensemble il y a compensation donc annulation. Il reste des défauts qui se compensent plus ou moins bien et leur réunion donne une évolution oscillante, en dents de scie. En changeant d’échelon, on peut passer à un autre palier tout aussi générateur d’un processus évolutif.

Le seuil d’action minimum h ou de sa réduction \= h/2f =

–10-34 joule / seconde, extrêmement faible, peut être franchi notamment dans l’échange matière – rayonnement qui s’exprime par des multiples entiers de h et se traduit par une onde oscillante de fréquence égale au multiple entier de h. La communication entre les particules opère de cette façon à une vitesse limite qui est de l’ordre de 300 000 km/seconde. Naît ainsi par paliers successifs un monde qui nous est perceptible. Mais les sensations que nous en avons masquent un nombre fantastique d’évènements qui se sont annulés par compensation et qui sont passés inaperçus.

Partant d’un hasard purement théorique nous parvenons en gravissant les divers échelons d’un hasard s’amenuisant, à un monde dont on peut évaluer les chances de se produire. C’est le calcul des probabilités qui n’est qu’un survol statistique de petits évènements aléatoires. Le probable se substitue à l’indéterminé. Chaque probable se situe à un écart déterminé de la moyenne. Ces écarts se répartissent sur la courbe en cloche. Il est bien sûr possible d’être de plus en plus précis et de réduire ces écarts de telle manière qu’ils parviennent plus ou moins à se confondre avec la moyenne. On peut ainsi parvenir aux énoncés déterministes de la mécanique newtonienne qui ne devient que la partie épurée de la mécanique quantique dont on a évacué le hasard par le tour de passe-passe de la compensation de petits évènements, sujet, eux, au hasard de plus en plus orienté. L’incertitude de départ rejoint ainsi la certitude qui, hélas, comme la moyenne ne peut être atteinte qu’à la suite d’une infinité d’expériences. C’est ainsi que le zéro d’en bas rejoint l’infini d’en haut, en partant d’un hasard théoriquement pur vers un hasard de plus en plus circonscrit sans jamais vraiment disparaître.

Tout cela ne peut se produire sans le grand nombre. Si l’on admet, comme la plupart des physiciens que le hasard est intrinsèque à la nature, il faut nuancer ce propos en disant que le hasard, d’abord sauvage, se civilise au fil du franchissement d’échelles. Mais ce qui reste fondamental c’est la quantité, sans laquelle tout cela ne serait pas possible.

Plutôt que le hasard, il vaut mieux affirmer que le grand nombre est intrinsèque à la nature du fait de l’impossibilité de l’isolement individuel. Même dans les grands collisionneurs où l’on essaie de s’affranchir de l’influence du milieu en se rapprochant du zéro et du vide absolus, on ne peut complètement éradiquer les affinités des particules entre elles. Dans des conditions exceptionnelles, on fait se heurter un nombre de particules. De l’analyse des chocs violents qui sont des rencontres par hasard, on en déduit les états de ces particules. Là aussi le hasard intervient pleinement associé au grand nombre.

Sans le grand nombre, un évènement hasardeux qui pourrait être isolé n’est rien. Ce n’est que l’association d’une appréciable quantité de ces évènements qu’il en ressort des effets qui sont à la portée de nos sens et de notre intelligibilité.

Le monde est sous la férule du grand nombre. Le loto n’aurait aucun intérêt s’il n’y avait un grand nombre de participants misant peu, mais motivé par l’appât du gain espéré, du à l’accumulation de petites mises. Comment cela a-t-il commencé ? Il a certainement fallu au début mettre en jeu des sommes alléchantes pour que le cycle du grand nombre de joueurs se produise, sans lequel rien ne serait possible. Dans la nature, il n’est pas nécessaire de créer le grand nombre, il est là.

Un être vivant est une manifestation du grand nombre. Il est l’effet résultant d’un grand nombre de cellules qui veulent vivre ensemble et se reproduire. La conscience émerge du cerveau par les milliards de neurones et leurs connexions. L’impénétrabilité de la table sur laquelle on travaille sans passer au travers est le résultat du comportement de milliards d’atomes qui sont pourtant constitués par du vide à presque 100 %. L’effet produit par une image en couleurs est dû au concours d’un grand nombre de pixels (picture element).

Quand on regarde évoluer une fourmi, on la voit se déplacer sans bien comprendre ce qu’elle fait. Pourtant, elle participe à l’activité d’une fourmilière dont elle n’est qu’un des nombreux individus. Sa mission est floue et pourtant elle va contribuer à la survie de l’ensemble. De même pour tous les autres insectes sociaux comme l’abeille, le termite. Le nombre d’Avogadro est la quantité de molécules d’un gaz quelconque contenues dans 22,4 litres à température et pression normales. Pour quelle raison ce nombre est-il toujours le même quel que soit le gaz concerné sous la condition qu’il soit éloigné de ses conditions de liquéfaction ?

C’est l’effet statistique qui en est responsable, ce qui se traduit par une température ou une pression constante qui sont conditionnées par le nombre de chocs entre elles ou sur la paroi du récipient des molécules du gaz. Il a été déterminé par J. Perrin que 22,4 litres de gaz peuvent contenir 6,022u1023 molécules aux conditions normales. Il est alors tout à fait envisageable qu’une moyenne statistique comme la température ou la pression s’établisse en dépit de l’énorme chaos créé par le heurt des molécules. Le grand nombre est lié à ces résultats. En matière d’économie il est certain qu’on ne peut connaître dans le détail les actes économiques de chaque individu d’une société. Keynes a pu cependant déterminer des grands leviers permettant d’agir sur l’économie en général d’un pays, comme, par exemple, la fixation du taux de crédit. Il est sûr que sans un grand nombre d’individus ces lois économiques n’ont aucune valeur. La quantité est toujours primordiale. On peut couper un cheveu en tirant dessus, mais cela est beaucoup plus difficile si les cheveux sont groupés en mèche. La propagation d’une onde sur l’eau calme d’un étang par le jet d’un caillou ne peut s’envisager que par le grand nombre de molécules d’eau dont le mouvement alternatif se communique les unes aux autres. Un président-directeur général d’une entreprise ne peut connaître ni agir sur tous les évènements qui vont conditionner le fonctionnement et la bonne marche de son entreprise elle-même. Les nuages sont la forme apparente de gouttes d’eau évaporées en énorme quantité.

On pourrait ainsi citer bon nombre d’exemples où le grand nombre est nécessaire pour y voir clair. Le mot de loi n’est pas approprié. Bien au contraire, ce qu’on appelle lois en physique auquelles la nature devrait obéir sans broncher n’est que probabilitaire. La loi de la gravitation universelle ne peut exister sans le grand nombre de particules qu’elle agrège. L’expansion qui lui est opposée est créatrice de grand nombre par sa faculté de dissociation. La nature n’a que faire des lois. Elle n’obéit à rien et n’en fait qu’à sa guise. L’effet statistique du grand nombre permet un point de vue synthétique, synoptique, global, holistique. Il faut en faire l’apologie, c’est une parure cosmétique du chaos. C’est une forme de réductionnisme, car il ramène un grand nombre d’évènements hasardeux c’est-à-dire sans que l’on puisse établir des liens entre eux, à des ensembles, à des regroupements où l’on peut trouver des relations causales et logiques. Dans ce sens, le grand nombre réduit l’incertitude et le hasard, gomme et efface beaucoup de petits évènements insaisissables par notre entendement. Il donne une apparence de continuité, comme un film qui n’est qu’une succession saccadée d’images.

La stratégie de laisser les choses aller au hasard serait ce que l’univers a trouvé de plus efficace pour faire apparaître un certain ordre de manière que l’homme puisse s’y retrouver sans que ceci soit vraiment imputable à la nature qui n’y est pour rien. L’effet compensateur n’est que la conséquence du hasard primordial. On s’appuie sur le grand nombre comme sur un réverbère qui éclaire des zones qui, sans lui, seraient dans l’ombre. Il est bien connu que si l’on veut trouver quelque chose, on cherche surtout là où il y a de la lumière. Le grand nombre rend visible ce qui est invisible. C’est un mode de lecture qui regroupe et associe, comme le langage, un certain nombre de lettres parmi la quasi-infinité de possibilités de réunir une trentaine de symboles. La nature est ébouriffée et échevelée. La loi des grands nombres la peigne et la coiffe.

On peut concevoir aisément que l’univers est lui-même un grand nombre qui augmente d’autant plus que l’expansion accomplit sa tâche de dispersion. Plus le nombre d’évènements est grand, plus il devient difficile de remonter leur cours. C’est l’irréversibilité du temps. Plus un corps est complexe plus il est difficile de le reconstituer, car il faut pour cela refranchir toutes les étapes de son évolution. Prenons simplement pour exemple une tasse de café qui est un objet parfaitement structuré. En mettant tous les atomes qui la composent dans un récipient et en le secouant pendant des siècles, il sera impossible de reconstituer cette tasse. Le hasard ne revient pas en arrière. Si cela était possible, les évènements antérieurs auraient été guidés non par le hasard, mais par déterminisme. Plus le nombre est grand, plus on réduit l’incertitude en allant vers la moyenne, mais plus il est difficile de remonter le cours de son évolution. Un fleuve tient son flux à la grande diversité de ce qui l’alimente, sources, cours d’eau, torrents, rivières… Il peut symboliser la loi des grands nombres où un grand nombre d’actions disparates se conjuguent pour lui donner un cours majestueux. Il finira noyé dans l’océan comme l’expansion finit par tout étaler et avaler.

Dans cette affaire de grand nombre, le dualisme y voit l’opposition de l’individu. Le citoyen d’un pays n’est rien en lui-même. Il acquiert sa force lorsqu’il s’assemble pour constituer une foule qui va se comporter par de grands mouvements bien souvent imprévus qui représentent mal l’addition des comportements de chacun.

« Le monde va à hue et à dia »

Le jeu de pile ou face,

atome du probable

Dans le jeu de pile ou face l’espace probabilisable se réduit à deux possibilités contraires l’une de l’autre, liées entre elles avec la certitude que si on voit pile, l’autre côté, caché, est face et inversement. Ce jeu est considéré comme l’atome des probabilités dans le sens où c’est l’élément de base de tout raisonnement probabiliste.

Il est insécable en deux éventualités indépendantes. C’est une situation aléatoire proprement irréductible, indécomposable en situations fortuites plus élémentaires. Aucun des deux termes n’est privilégié par rapport à l’autre. C’est en principe la liberté d’indifférence, aucune issue n’ayant une influence sur l’autre. C’est l’âne de Buridan mourant de ne pouvoir choisir entre assouvir sa faim et apaiser sa soif, en théorie tout au moins.

Ce couple dualiste basique comporte seulement deux possibles dont l’un est l’opposé de l’autre. La mise en opération de ce jeu comporte d’abord une phase d’identification. Il faut convenir des règles de ce jeu. Cela consiste d’abord dans la définition de face et pile, le côté face étant celui où il y a une figure. Ceci se fait à l’état de repos, de stabilité. On donne ensuite à la pièce de monnaie, par un geste de lancer, un mouvement linéaire et rotatif. La pièce tournoie tout en parcourant sa parabole comme un boulet de canon. Quand elle est en l’air, elle n’est pas identifiable par ses faces qui prennent des positions hors de tout contrôle. On peut dire qu’elle est « à la fois » pile et face. Dès que la pièce entre en contact avec un plan horizontal et s’immobilise, alors l’imprécision sur sa position est levée. Cela devient une certitude. Elle est pile ou face. Il faut se rappeler la convention de départ, la mémoire ayant été perdue pendant la durée de vol. L’alternative n’est plus. Nous « savons » sûrement qu’il n’y a que deux issues possibles opposées. C’est l’une ou l’autre. Il s’agit d’un processus de connaissance ou plutôt de reconnaissance à partir de données pré-établies. Conditions initiales et finales sont identiques. Entre les deux, on introduit un processus dit de hasard. Du fait de l’agitation de la pièce, aucun repère n’est plus possible. C’est l’ignorance.

Mais on ne peut avoir deux jets parfaitement identiques. Même si ce pouvait être le cas, la Terre et tout son cortège se déplacent. Il y a un décalage espace-temps qui modifie légèrement le jet. On peut simplement dire : il y a un parcours entre deux positions de repos qui peuvent être inverses l’une de l’autre ou identiques. C’est un phénomène de symétrie et d’inversion dont seule la nature est capable et prodigue. Mais la nature est faillible et entre, soit une reproduction à l’identique, soit une inversion qui est aussi une opération de symétrie associée à une rotation d’un demi-tour, ils se glissent des défauts minimes qui ne modifient pas notablement le parcours. Ces fautes vénielles et mineures de reproduction à l’identique, d’évènements réputés indépendants les uns des autres vont provoquer une dispersion des résultats sur une courbe en cloche.

Il peut se produire des gros défauts de reproduction, mais ils sont beaucoup plus rares et ils finiront bien par se compenser au bout d’un temps qui peut être éventuellement très long.

Ce qui est fantastique dans le jeu de pile ou face c’est la simplicité de ce jeu et son irréductibilité d’une part et d’autre part le fait que si l’on répète ce jeu un très grand nombre de fois, on obtient à peu de chose près, une égalité de nombres de piles et de faces. On dit que, en jouant une infinité de fois, la probabilité s’approche d’une moyenne de 1/2 pour obtenir cette égalité.

Il est bien entendu que nul génie malicieux ne rééquilibre le nombre de piles et de face et pourtant l’expérience démontre bien cela, intrigant ainsi bon nombre de scientifiques. Il apparaît que la seule explication possible est le phénomène de compensation. Le lancer est constitué par un mouvement principal et un très grand nombre d’évènements microscopiques non détectables, mais d’importance progressive. On a ainsi à toutes les échelles un ensemble de phénomènes qui sont pour la plupart opposés et par conséquent s’annulent. Il reste à toutes les échelles des évènements résiduels qui se superposent pour finir par être perceptibles et se placer sur la gaussienne. Le nombre de piles et le nombre de faces vont ainsi osciller autour de la valeur moyenne : 1/2. Le rapprochement vers la valeur moyenne n’est pas progressif. Un même joueur peut gagner pendant 75 % du temps avec une probabilité de 0.66 qui tombe à 0.2 pour 97 % du temps. Nous voyons bien ainsi que le jeu de pile ou face est bien imprévisible. Il est impossible de prévoir quel côté va sortir, l’antériorité n’ayant aucune influence sur le résultat. C’est la totale surprise.

Le dualisme pose l’hypothèse que l’univers ne soit qu’un immense jeu de pile ou face qui s’établit au voisinage du zéro absolu pour devenir perceptible par nos moyens. Il s’agit d’une fantastique pelote indémêlable. Tout le calcul se ramène à cet atome du probable. L’univers peut se figurer sans doute, par une courbe en cloche où l’énergie se regrouperait au sommet en un point infime où il n’y aurait pratiquement plus d’écarts, d’accès quasi impossible. L’énergie s’étale de chaque côté soit pour se regrouper dans la moitié gauche de la courbe soit pour s’étaler dans la partie droite où nous vivons d’une manière quasi certaine.

Le dualisme est convaincu que tout se joue à pile ou face.